¿Necesitamos saber manejar una Reverb? ¿O aprender a controlar un ecualizador? ¿O decidir en nuestra guitarra si va primero el pedal de Flanger y después el de Distortion?, entonces reflexionemos un poco antes de adentrarnos en ello. Muchas veces oímos palabras que (a fuerza de tanto sonar) resultan familiares pero carentes de fundamentos efectivos: DSP, Efectos, Chorus, Delay, etc. Para comprender el uso de los efectos en cualquier situación de mezcla o post producción, es menester que revisemos en profundidad lo que significa «procesar una señal sonora». Si nos tomamos unos minutos para reflexionar ahora en lo más elemental, cuando tengamos que afrontar una situación compleja de mezcla, nos ahorraremos mucho tiempo. Se los aseguro.

¿Necesitamos saber manejar una Reverb? ¿O aprender a controlar un ecualizador? ¿O decidir en nuestra guitarra si va primero el pedal de Flanger y después el de Distortion?, entonces reflexionemos un poco antes de adentrarnos en ello. Muchas veces oímos palabras que (a fuerza de tanto sonar) resultan familiares pero carentes de fundamentos efectivos: DSP, Efectos, Chorus, Delay, etc. Para comprender el uso de los efectos en cualquier situación de mezcla o post producción, es menester que revisemos en profundidad lo que significa «procesar una señal sonora». Si nos tomamos unos minutos para reflexionar ahora en lo más elemental, cuando tengamos que afrontar una situación compleja de mezcla, nos ahorraremos mucho tiempo. Se los aseguro.

Introducción:

Antes de adentrarnos de lleno en el tema, deberíamos reflexionar que existen muchos tipos de procesos de la señal. porque existe muchos tipos de señales. La palabra DSP (Digital Signal Processing) no se ciñe únicamente al mundo del sonido. Estamos llenos de procesos digitales de la señal, el video se puede manipular y transformar digitalmente, las imágenes también, y también son procesos DSP cualquier tipo de proceso que involucre datos digitales.

Ahora bien, ¿solo se pueden procesar las señales digitalmente?: Definitivamente NO. Y en muchos casos, ya hablando de la señal sonora,recurrimos a un sinfin de procesos de la señal de audio y no todos ellos son digitales. Entrando en el mundo del audio, deberíamos de recordar que las únicas dos magnitudes que cuentan para el sonido son: Presión Sonora y Tiempo. T

odos los demás parámetros del sonido: La frecuencia, el timbre, las envolventes, los ecualizadores, los compresores, la reverberancia, el eco, y todo, absolutamente todo, puede explicarse con esos dos únicos conceptos. (si algunos de estos términos te resultan difíciles, puedes consultar nuestros artículos de acústica básica para ayudarte a fortalecer la plena compresión de este tópico que estamos cubriendo).

Definimos un proceso de señal (SP) como cualquier método ya sea mecánico, analógico, eléctrico, electrónico o digital, que nos permite transformar una señal sonora original (S0) en otra señal sonora resultante que guarde mayor o menor grado de identidad con la señal original.

Cuando un pianista pisa el pedal de sustain de su piano de cola, esta efectuando un proceso de la señal. Cuando estamos cantando, a medida que modulamos la boca y la laringe, modificamos el sonido que emiten las cuerdas vocales, afianzando la afinación en las vocales y creando los fonemas con consonantes (que son ruidos) que ayudan a comprender el significado.

Cuando un trompetista le coloca al instrumento una sordina, o cuando un guitarrista pisa un traste en el mango de la guitarra para acortar la cuerda, también están haciendo un procesamiento de la señal. En todos estos casos, hablamos de lo que me atrevo a definir como «Procesos Mecánicos de la Señal» ó MSP (Mechanical Signal Processing).

Si creías que el efecto de Wah Wah era exclusivo de las pedaleras de los guitarristas eléctricos, te invitamos a ver este video breve con un ejemplo de MSP:

Cuando subimos el volumen de nuestro televisor, cuando transformamos la voz humana con un micrófono en una señal que nos llega al sistema de grabación, o en amplificamos el bajo en un show, estamos realizando una operación analógica de procesamiento de la señal ASP: (Analog Signal Processing).

Ahora bien, Cuando usamos un plug-in en el ordenador, o cuando levantamos muestras a un sampler, o editamos parámetros en un sintetizador digital, estaremos hablando de un procesamiento digital de la señal ó DSP (Digital Signal Processing). La misma conversión analógica que realiza tu placa de sonido antes de que puedas grabar en tu programa favorito, tiene muchos procesos de manipulación de la señal digitalmente.

Mas allá de cual fuere el entorno en el que procesamos las señales de audio, los procesos tienen varios ejes de análisis que comparten varias cosas en común, desde el punto de vista metodológico. Para la mayoría de los músicos y técnicos de sonido. muchos procesos, pasan inadvertidos por estar tan familiarizados naturalmente con ellos.

La identidad de la señal después del procesamiento:

Cuando hablamos de Procesos de la señal mucha gente piensa en los efectos. Aquellas manipulaciones que hacer el ingeniero de sonido para terminar un producto grabado (EQ, compresión, Envíos de Reverb. Chorus, etc.) Pero, los constructores de instrumentos, los diseñadores de amplificadores, los diseñadores de sonido, los intérpretes, y hasta los compositores y arregladores, estamos sin duda permanentemente transformando señales sonoras.

Entonces, ¿que es un efectos de mezcla? Si estiro la clavija del violín sin duda estoy cambiando la afinación y eso no es un efecto. Tampoco dejo de sonar a violín. ¿Entonces? Bueno para no desviar la discusión (necesaria por cierto) vamos a centrarnos en lo que generalmente más dudas conlleva: Los efectos para la mezcla.

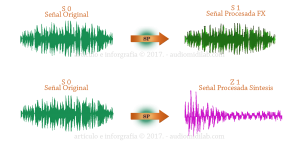

La diferencia entre considerar un Procesamiento de la Señal como un efecto (FX) o una variación necesaria de algún parámetro sonoro , reside en la relación de identidad que guardan ambas señales entre si. Es decir si la S0 (señal original) después del procesamiento conserva características que la siguen identificando a pesar de ser una S1 (Señal Procesada), hablamos de EFECTOS. Si en cambio luego de procesar la S0 obtenemos una señal que guarda poca identidad con la original, Z1 (Señal Procesada) probablemente estemos hablando de SINTESIS.

Ya que el procesamiento de las señales es uno de los principios básicos de los sintetizadores, no debería escandalizarnos esta última afirmación. Cualquier guitarrista desde el momento que decide como conectar sus pedales, está modelando el sonido de tal forma, que es sin duda un DISEÑADOR de SONIDO. Hay algunos plug-ins que mas que considerarse como fx, son verdaderos sintetizadores de la señal, ya que el resultado obtenido no guarda relación de discernimiento con la señal original. En la gráfica siguiente se explica la diferencia:

La perceptibilidad en el tiempo:

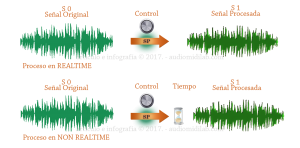

Los procesos pueden ser REAL TIME o NON REAL TIME. Esto significa en primer término que en la medida que provocamos una variación de un control, sin demora perceptible, escuchamos una variación en la señal. En los procesos digitales NON REAL TIME, se requiere un tiempo de cálculo (mínimo o eterno según la potencia del sistema) pero perceptible como una demora en variar la señal.

También cabe decir que en el entorno de los DSP, no existe el tiempo de cálculo INSTANTÁNEO. Todo proceso digital lleva (por la propia arquitectura de los microprocesadores) un tiempo de cálculo. Solo que es (o debiéra ser) IMPERCETIBLE.

Cuando comienza a ser perceptible, es decir cuando empezamos a exigirle al sistema que ante una variación entregue un resultado y ocurre que sentimos que la respuesta no es inmediata, entonces estamos hablando de LATENCIA del sistema. Y estoy seguro que a medida que comiences a usar mas recursos de tu sistema digital, vas a tener que lidiar con este tema de la latencia. Pero eso un tópico que abordaremos en artículos subsiguientes.

La conservación de la señal original:

Pueden ser DESTRUCTIVOS o NO DESTRUCTIVOS. Cuando hablamos de procesos no destructivos (no nos referimos al UNDO de Sound Forge) sino a que las señales resultantes son calculadas a expensas de la señal original, sin que la señal original se pierda definitivamente. Por ejemplo si grabamos una voz con el ecualizador de la consola activado antes del sistema de registro, estamos destruyendo parte del espectro original, que nunca más recuperaremos. En cambio si grabamos directamente la voz en el sistema de registro y usamos el ecualizador en la vuelta hacia la mezcla, la señal original siempre estará allí.

Naturaleza de los procesos:

Ya lo decíamos antes pero vale la pena reiterarlo, los procesos pueden ser mecánicos, analógicos, digitales, o también una combinación de estos. Pensemos en este caso: Un cantante siendo grabado en un estudio que tiene una consola digital, pero usa una cámara de resonancia natural (Una pequeña caverna en forma de U que se suele construir en los sótanos de algunos estudios muy profesionales para tener una reverberación natural). Y eso es todo.

Así se grabará y se mezclará la toma. Pero, si desglosamos los procesos por los que pasa la señal, nos sorprenderíamos de lo complejo y variado que resulta ser. Solo como un ejercicio, recorramos juntos ese proceso, paso a paso.

Un cantante está emitiendo su voz por un micrófono, el micrófono entra a nuestra consola digital, un bus de esa consola lo usamos para enviar una señal amplificada hacia un altavoz ubicado en una sala natural de reverberación (Una pequeña caverna en forma de U que se suele construir en los sótanos de algunos estudios muy profesionales para tener una reverberación natural), recogemos la señal con otro micrófono en la cámara de reverberación y lo volvemos a traer a nuestra consola digital, allí lo mezclamos con la señal original de la voz. Obtenemos una voz con reverb. Pero hemos pasado por ASP, DSP, ASP, MSP, ASP, DSP, DSP y de alli al sistema de amplificación (ASP) y el monitoreo final se expresará expulsando sus altavoces en variaciones de presión sonora en el ambiente. (MSP) .

| Situación: | Proceso | ||

|---|---|---|---|

| Tenemos un cantante emitiendo su voz para grabar la toma |  |

MSP | |

| El micrófono toma la señal vocal,convirtiendo la Presión sonora en impulsos eléctricos. Está conectado por un cable a la consola de mezclas |  |

ASP | |

| En una consola digital, el conversor ADC trae la señal a un canal y convierte las variaciones de potencial eléctrico en D-WORDS. Codificación digital |  |

DSP | |

| Como se quiere usar una Reverb Natural, la señal es enviada por un bus auxiliar. |  |

DSP | |

| La salida del bus es amplificada, y esa amplificación como señal eléctrica, llega a un altavoz dentro de la sala de resonancia. |  |

ASP | |

| El altavoz se expresa transformando la señal eléctrica en cambios de presión sonora |  |

MSP | |

| La sala de resonancia le suma sus reflexiones y coloración reflejando la señal de presión sonora |  |

MSP | |

| Un segundo micrófono recoge la vibración del altavoz con todas las resonancias que le agregó el espacio natural. |  |

MSP | |

| Transforma la presión sonora en variación de potencial eléctrico que viaja por un cable. |  |

ASP | |

| La señal de las reflexiones de la cámara, llegan al conversor ADC de otro canal de la consola de mezclas. |  |

DSP | |

| El técnico decide ecualizar la señal de la reverb para poder colorearla de acuerdo a su gusto. |  |

DSP | |

| La suma de los dos canales, el de la voz «seca» con la señal de las reflexiones, se mezclan (retornando la reverb por canal en lugar de hacerlo por auxiliar) y van a un subgrupo. Que se sumará al resto de la mezcla de los otros canales. y de ahí al master. |  |

DSP | |

| La salida del master es convertida de digital a analógico (DAC) para pasar al sistema de amplificación. |  |

ASP | |

| La potencia envía impulsos de corriente por los cables a los monitores de campo cercano del ingeniero de sonido. |  |

ASP | |

| Los altavoces de los monitores, convierten la suma de todas las señales en presión sonora dentro del Control Room. |  |

ASP | |

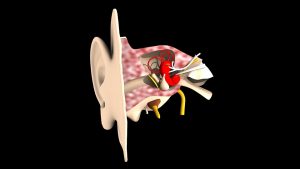

| El técnico de sonido escucha la mezcla con sus oídos. La presión sonora se transfiere al tímpano.. |  |

MSP | |

| El tímpano transfiere la energía en movimiento mecánico a la cadena de huesecillos que hay en el oído medio.. |  |

MPS | |

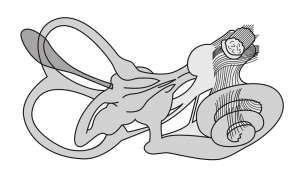

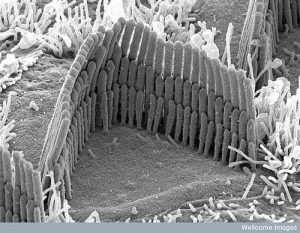

| Los husecillos vuelven a transferir la energía esta vez en el interior de la Cóclea, convirtiendo el movimiento mecánico en hidraúlico |  |

MSP | |

| El movimiento del liquido dentro de la cóclea mueve las cilias del oído interno, agitándolas de manera mecánica |  |

MSP | |

| En la base de las cilias las terminaciones nerviosas que se concentran en el órgano de Corti intercambian iones de Potasio y Sodio, para generar las diferencias de potencial eléctrico |  |

ASP | |

| la electricidad generada viaja al cerébro en donde se decodifica la sensación de sonido |  |

ASP |

Los múltiples procesos:

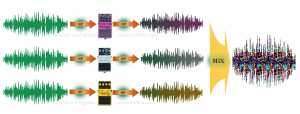

Los procesos múltiples pueden ser secuenciales (cadena) o en paralelo. En los procesos secuenciales la S0 pasa por un proceso, se convierte en S1, la señal S1 se convierte en S2 y asi hasta la SR. En este caso es de vital importancia el orden en el que se realizan los procesos, ya que depende el orden dentro de la cadena, la señal resultante final no será igual en cualquier situación. No es lo mismo comprimir y después ecualizar que al revés, por ejemplo.

En los procesos en paralelo la S0 es procesada por varios controles a la vez y las señales obtenidas: S1, S2, S3, etc, son mezcladas y posiblemente amplificadas por la sumatoria de dinámicas, en una señal final resultante: SR

Los parámetros procesados:

Los procesadores normalmente actúan sobre uno o más de los parámetros del sonido. Encontramos aquellos que operan sobre el tiempo: Phasing, chorus, reverb, delay, etc. Otros actuarán sobre la dinámica : Volumen, compresores, limitadores, expansores, puertas de ruido,etc. Otros actuarán sobre el espectro: Ecualizadores, filtros Wha Wha, Filtros polares, etc. Y otros procesarán la frecuencia del sonido: Pitch Shifter, Octavador, Autotune, etc.

Algunos procesos involucran operaciones complejas en done más de uno de estos parámetros es procesado. Ejemplo el Melodyne.

Ultimas Reflexiones:

Queda tema para rato, en sucesivas entregas iremos conociendo uno por uno los efectos, de más está decir que necesitaremos para los siguientes artículos algunas nociones extra de acústica, asi que a revisar en la biblioteca de nuestro sitio aquellos conceptos que estén mas flojos, para poder aprovechar mejor las notas que vendrán.

Te dejamos dos ejemplos audiovisuales de REBERVERANCIAS cuyo origen es mecánico y luego analógico:

- Las reverbs del tipo SPRING (Resortes) y las de PLATE (placas)

- ¿Cómo funcionaría una reverb Natural para tu estudio?

Angel Diego Merlo

El presente artículo ha pasado las verificaciones del Consejo Académico de Audiomidilab, y por lo tanto se encuentra certificado por los especialistas del área. Eso quiere decir que es formalmente correcto y resulta ser una fuente de información confiable. Todo artículo que escribe un autor o submite un corresponsal o colaborador, es pasado por este riguroso sistema de certificación.

El presente artículo ha pasado las verificaciones del Consejo Académico de Audiomidilab, y por lo tanto se encuentra certificado por los especialistas del área. Eso quiere decir que es formalmente correcto y resulta ser una fuente de información confiable. Todo artículo que escribe un autor o submite un corresponsal o colaborador, es pasado por este riguroso sistema de certificación.

©2004 Audiomidilab.com. Todos los derechos reservados. El editor puede haber incluido contenidos audiovisuales en enlaces externos que corresponden a terceros. Invocando el derecho a cita con fines educativos.

© 2005-2017 audiomidilab.com Derechos reservados.

Por Angel Diego Merlo – diego@audiomidilab.com

Nivel recomendado de lector: Intermedio