¡Volver al pasado, para comprender el presente e imaginar el futuro!

♦│MIDI│Fundamentos│ ¿Por qué? ¿Para que sirve? ¿Cómo lo implemento? Por prejuicios, por ignorancia, por mala información, en pleno siglo XXI, todavía encuentro productores musicales o aficionados que tienen en su cabeza el concepto de que «EL MIDI ES OBSOLETO», o «EL MIDI SUENA MAL», o cualquier otro tipo de información errónea. En este artículo re visitaremos la Norma MIDI desde su punto de vista histórico y desde el increíble potencial, que todavía tiene y que aún no es utilizado por la mayoría de los usuarios, simplemente por mala información.

Una pequeña aclaración previa

Cuando realicé la primera versión de este artículo en 1997, El MIDI y el Audio Digital eran tecnologías relativamente accesibles al nivel del consumidor doméstico. Hacia finales de los ochenta, la tecnología MIDI estaba establecida en el mercado profesional de la producción musical como una herramienta indispensable en cualquier plataforma, y no existía ningún instrumento musical electrónico que no incluyera su implementación.

Aún hoy después de más de 30 años de existencia (que en términos de tecnología equivalen a 30 siglos) no ha podido ser ni desplazada ni reemplazada por ningún otro standard. Lo que quiere decir, que trabaja eficientemente, y que fue bien pensada desde su origen para alcanzar la escalabilidad necesaria casi medio siglo después.

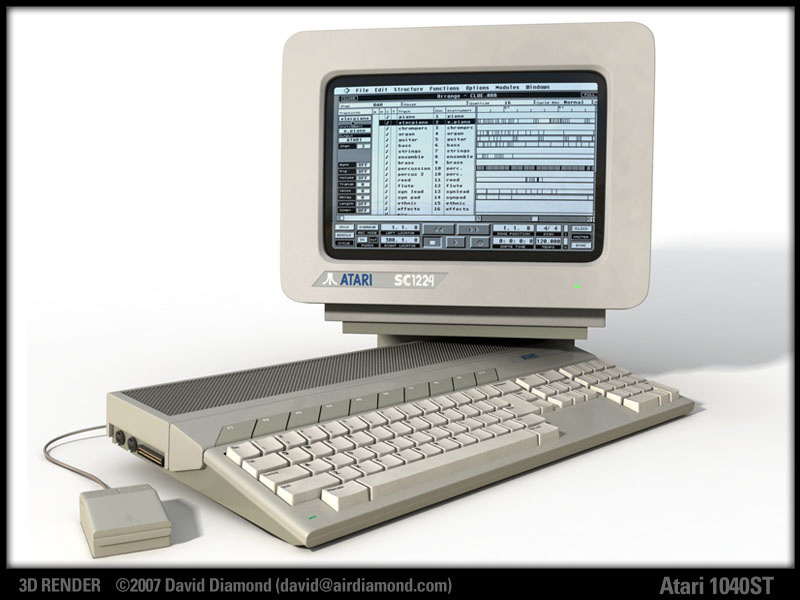

En 1989, Atari ya sacaba sus ordenadores con interfase MIDI de serie (STE 512) y otro tanto hacía Mac.

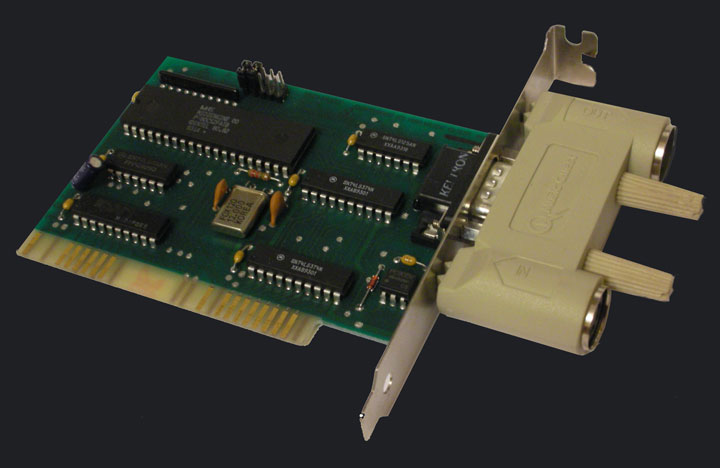

En el mundo PC, con sistemas operativos como DOS y el recién llegado Windows 3.1 con su propuesta de escalabilidad, no incorporó nunca interfase MIDI. Las soluciones para PC se basaban en agregar placas internas, como la legendaria Roland MPU-401 o la mítica Sound Blaster 16. Y en los inicios, cuando la tecnología plug & play era básicamente desastrosa, configurar un plaqueta de sonido dentro del CPU era algo así como un trabajo digno de un ingeniero de la NASA.

Hacia 1991, Roland ya había introducido el concepto de GENERAL MIDI (En principio a través de una norma interna GS, que luego fue adoptada por las otras compañías y paso a llamarse GM). Para el año 1992 ya estaba establecida hasta la norma GM (General MIDI) y el archivo SMF (Standard MIDI File) más conocido por la extensión del archivo. «*.mid».

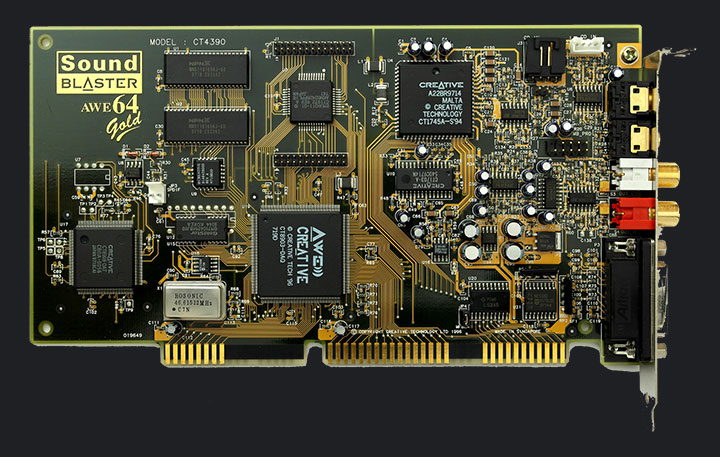

En 1994, Sound Blaster 16 Se constituía un estándar para el PC, dotando además de la posibilidad de grabar audio digital, con una resolución de 16 bits y 44,1 Khz de frecuencia de muestreo.

Para 1996, Sound Blaster ya había producido su plaqueta de sonido AWE32 y AWE64 que incluían un sampler de excelentes prestaciones, basado en el chipset del sampler EMULATOR, el EMU 10k1. Pero, para no perder compatibilidad con los juegos y aplicaciones previas, incluye además de la compatibilidad con MIDI externo, el sintetizador interno de Yamaha OPL3 (síntesis FM). Y ahí reside el origen del mito «EL MIDI ES UN JUGUETE QUE SUENA MAL».

La mayoría de los usuarios hobbystas, que no comprendían la utilidad del MIDI como protocolo de comunicación, ni el poderío de la síntesis FM, tal como el DX7 de YAMAHA, había probado ser. Asociaron el sonido del chipset OPL3 como el sonido del MIDI. Ignorando que el MIDI es solamente un lenguaje de órdenes que no conlleva sonidos en si mismo y que depende de un sintetizador para general el audio.

¡Y en rigor del verdad el YAMAHA OLP3 sonaba bastante horrible!. Agregémosle que los que hacían las secuencias en formato MIDI FILE (extensión.mid) abusaban bastante de la Cuantización y ABSOLUTAMENTE ESTE NO ERA UN DEFECTO del SOFTWARE de producción MIDI, sino un mal hábito de los productores, que le quitaban toda frescura y espontaneidad a la interpretación musical. Esos dos factores, sumados al desconocimiento del usuario hogareño, y la irrupción masiva en el mercado del sistema operativo Windows 95, arrogándose la creación de la multimedia (cuando en realidad, en el mundo de los ordenadores Atari y MAC ya tenían todo un camino profesional recorrido) fueron los que hicieron que muchísimos músicos, técnicos, y hobbystas, por IGNORANCIA, esgriman la tristemente famosa frase de «¡El midi suena feo!» Cuando todos sabemos que el MIDI, No suena por sí mismo.

Escuchemos ahora el mismo archivo midi original de Windows 95, interpretado por el chip de OPL3 de la Sound Blaster 16 y lo comparamos luego con una versión cuyos datos MIDI, van a parar a un puerto externo que los hace reproducir por un sintetizador Roland SC-55

Año 1995. La versión del sintetizador incorporado de Yamaha en la Sound Blaster 16 por el chip de FM de OLP3 de YAMAHA, síntesis FM.▼

Año 1992. Exactamente el mismo archivo (de 1995), ejecutado por un Roland Sc-55 Síntesis PCM (Lector de Samples) tecnología profesional para 1992 ▼

Año 2015, SWAM, con su instrumento virtual CLARINET, demuestra que los mensajes MIDI son esenciales para lograr un realismo expresivo, más allá de la calidad innegable del motor de síntesis. ▼

Para contrarrestar todos estos prejuicios y demostrar la vigencia de la norma, les acercamos un video de un instrumento virtual, controlado por teclado, Breath Controller (CC#2) y si observan con atención, el secreto del sonido no está en la síntesis unicamente, sino en cómo el sintetizador interpreta los mensajes MIDI. Año 2017. SWAM- The Violín ▼

¿Por qué el MIDI? ¿Cuales fueron sus orígenes? ¿Que detonó la necesidad de un protocolo de comunicación entre instrumentos musicales?

Si intentamos hacer un poquito de memoria, no está muy lejos la época en que veíamos (y escuchábamos) a los tecladistas de los grupos, rodeados de una enorme montaña de aparatos y con cables saliendo y entrando por todos lados…

Parecía que los pobres no daban abasto y a menudo las bandas tenían más de un tecladista para poder tocar todos los teclados a la vez. (todavía los pulpos no habían aprendido la técnica pianística). Ahora bien, alguna vez te preguntaste ¿por qué eran necesarios tantos teclados?. Hay una posible explicación.

La historia del sintetizador es sin duda la historia de la conquista del control del timbre. Desde tiempos inmemoriales, los hombres han soñado con poder tener el NIRVANA DE LOS INSTRUMENTOS. El «instrumento» que puede reemplazar a TODOS los demás instrumentos.

Y eso sin duda, fue el incio de todo. Y ocurrio en gran medida con la invención del Órgano de Tubos. El concepto del órgano de tubos era el de lograr un instrumento que pudiera al menos reemplazar a una orquesta.

Con sus diferentes colores de tubos (pipes), tenía registros de «maderas», «bronces», graves profundos y poderosos. El único problema es que no podía tener la sutileza de articulaciones tímbricas de un oboe o una flauta, ni el control de dinámicas de una trompeta.

Pero su magnificencia se basaba simplemente en : ¡APILAR ARMÓNICOS, sumando «sonidos simples», (REGISTROS) para crear un timbre mucho más complejo.! No negamos la belleza de la música de órgano. Pensar en la historia de la música sin él sería un gran error y la música no hubiera evolucionado del mismo modo sin su existencia. (Al igual que con la invención del sintetizador).

En el ejemplo, un clásico de la música para órgano. Si observamos los teclados están acoplados, es decir, el único modo de obtener variaciones de timbre en tiempo real, es cambiar los registros. ▼

En profundidad: Para quienes quieran comprender el órgano de tubos en profundidad les presentamos el siguiente documental ▼

La invención del sintetizador, no estuvo lejos de estas cuestiones tampoco. En realidad el primer sintetizador (síntesis aditiva, suma ondas sinusoidales simples para crear un espectro más complejo) fue el thelarmonium, le siguieron las ondas maternot, el theremin y un muchos otros intentos más. Pero quien realmente produjo el primer impacto comercial a gran escala, fue Robert Moog, con la invención del sintetizador modular.

En esta obra de 1969, se utilizó un MOOG MODULAR, para realizar varias sobregrabaciones y obtener la obra completa. Aquí podemos oir a Hans Wurman en esta hermosa version de «Toccata y Fuda en Re Menor», de J. S. Bach. ▼

En esos primeros tiempos, se usaban osciladores controlados por voltaje (VCO) para producir ondas elementales, que luego eran modeladas por el sistema de filtros y procesos analógicos de la señal. Un generador de envolvente (ADSR: Atack, Decay, Sustain y Release) permitía modelar la amplitud y tratar de modificar el comportamiento de la onda en tiempo real. En las primeras épocas de los sintetizadores, la búsqueda del timbre era impulsada por la necesidad de tener nuevos sonidos, que hasta ahora los instrumentos acústicos no nos habían proporcionado. La carrera armamentística hacia la EMULACIÓN todavía estaba lejos de comenzar. Lo que sí ocurría con los primeros sintetizadores, es que eran MONOFÓNICOS, o tenían muy pocas voces de polifonía. 2, o 4 voces era todo un lujo en 1969.

No es el objeto de este artículo hacer una historia de los sintetizadores, sino del MIDI, por esa razón simplificaremos la cuestión arbitrariamente, diciendo que: Con el correr del tiempo, la cantidad de polifonía pudo llegar a ampliarse a 6 voces, y con el correr del los años, entre los 70 y los 80, la polifonía de un sintetizador, ya se acercaba a las 16 voces simultáneas.

El problema de la polifonía era básicamente un problema de costos. Si se necesitaban más voces, había que poner mas VCO´s. Y eso encarecía el precio final. Entonces, el camino a llegar como hoy a 500 voces de polifonía, fue un largo proceso de reducción de costos, que implicaría desafíos tecnológicos innovadores. Como los teclados que se fabricaban no tenían demasiadas voces a la vez, y por sus técnicas de síntesis, no lograban espectros demasiado complejos, como una sección de cuerdas, o unos buenos sonidos de bronces, los tecladistas de bandas exitosas de la época, comenzaron a utilizar varios teclados en su set de vivo.

En el estudio uno podía realizar sobregrabaciones, pero en vivo, era necesario tener acceso inmediato al sonido. Por otra parte, los primeros sintetizadores, se configuraban sus sonidos a mano. No podían «guardar» su configuración de paneles (PATCHES) en otro lugar que no fuera un papel o la memoria del intérprete. Y cambiar de sonido entre tema y tema o entre una frase musical y otra, era prácticamente dificultoso. ¡Esa es la época en que los tecladistas necesitaban una silla giratoria, para poder acceder a todos sus instrumentos!

De a poco fue calando en los músicos y en los fabricantes de teclados la idea de poder simplificar esta engorrosa cuestión, y así nació la idea de intercomunicar aparatos musicales. Es decir de poder tocar desde un teclado y hacer que suene otro. Luego de algunos toscos intentos, allá por el año ´78, finalmente todos se pusieron de acuerdo y generaron un método de comunicación estándar, con su lenguaje propio y su “hardware” específico. Dave Smith de Sequential Circuits, fue uno de sus grandes impulsores. Dicho Estándar de comunicación fue bautizado “MIDI” es la sigla que se forma con el concepto de MUSICAL INSTUMENTS DIGITAL INTERFASE.

Simplificando un poco las cosas, podemos adelantarte que se trata de un protocolo de red para instrumentos musicales, con sus características propias. Es SERIAL. La información MIDI siempre se sucede como una serie de impulsos codificados que van uno detras de otro. Incluso cuando tu oído escucha un acorde o una orquestación compleja en el mismo módulo de sonido.

No hay simultaneidad de información. Lo que ocurre es que al viajar la información a 31,2 kbaudios (bits x segundo), es auditivamente imperceptible la no simultaneidad.

A continuación te ofrecemos una entrevista (en inglés) con Dave Smith, uno de sus mayores impulsores y colaboradores ▼

El siguiente informe en video de la MMA (Midi Manufacturers Asociation) te cuenta ilustradamente la historia del MIDI en homenaje a sus 30 años de vida y la importanciia de su vigencia ▼

Y como curiosidad te contamos que se usaron los conectores de 5 pines, porque eran los más baratos del mercado en esa época (dado que la industria del audio había virado hacia los conectores RCA y dejado en desuso los DIN de 5 pines). Es dable pensar que a la hora de establecer ideas de reducir los costos, el argumento de usar estos conectores resultó la mejor eleccion del momento. Se puede transmitir información MIDI por cualquier cable de 3 hilos, de hecho algunos fabricantes lo hicieron con plug stereo y en algunos casos por conexiones xlr.

Actualmente casi todos los sintetizadores profesionales traen además de los conectores MIDI estándares, una opción de USB host, para poder conectarlos via cable USB. Con un driver apropiado que transforma al cable en una interfase MIDI en sí misma.

Inmediatamente después de hacer su aparición, el MIDI revolucionó el mercado musical, las técnicas de producción de discos, el trabajo del compositor y de los editores de música ya no serían lo mismo sin él. Como es un protocolo amplio y bien previsto, se utilizó para aplicaciones musicales, pero también para robótica de luminotecnia, control de maquinarias de escenarios y cualquier tipo de situación en la que las ÓRDENES tuvieran que ser sincronizadas a un tiempo musical.

El MIDI que llegó en 1983 por primera vez de la mano del Prophet 600

y en paralelo Roland Jupiter 6, implementaba el MIDI. De hecho fueron los dos primeros sintetizadores que establecieron una conexión MIDI entre sí.

Un poco más tarde, YAMAHA se sumaba al desafío con su legendario Yamaha DX7

De ahí en más, con el paso del tiempo, otras compañías fueron incorporando la norma MIDI hasta que en 1990, ya era un estándar obligatorio para cualquier instrumento electrónico. El MIDI, gracias a sus posibilidades y especificaciones, permanecería vigente hasta hoy, en pleno siglo XXI.

¿Para qué el MIDI? :

Hoy por hoy, el MIDI, al alcance de todos desde el punto de vista económico, nos permite entre otras cosas:

Enriquecer el espectro de nuestros timbres, pudiendo tocar desde un teclado, una batería electrónica o cualquier tipo de controlador alternativos, y hacer que suenen otros sintetizadores a la vez, logrando timbres más ricos y sonoridades más arriesgadas.

Registrar nuestra ejecución dentro de una computadora utilizándola como un estudio de grabación realizando una secuenciación de datos MIDI. Además de que podemos tener muchos puertos MIDI dentro del mismo programa, Ampliando con la suma de los instrumentos virtuales (que cada uno de ellos genera un puerto MIDI virtual propio), las combinaciones son infinitas e inagotables.

Utilizando software adecuado, podemos mejorar nuestros estudios de composición, arreglos y armonía, ya que todo lo que ideamos lo podemos probar con nuestros teclados. Además de poder utilizar potentes editores de partituras que nos permiten comunicar nuestras ideas digitales a músicos reales.

Economizar tiempo y dinero a la hora de sacar a luz nuestra producción musical, ya que solo grabamos en el estudio nuestras voces (el resto está hecho en casa con la computadora).

Obtener riqueza expresiva inimaginable, con el uso de superficies de control, para poder modelar el sonido de los sintetizadores (ya sean de hardware o de software) obteniendo un plus indispensable para las necesidades expresivas de la producción musical actual.

Automatizar procesos en el estudio o en el vivo, tales como tener un control remoto via MIDI que nos permita manejar el programa de grabación de audio digital y hasta la automatización de la consola de sonido, y los sistemas de luces. y hasta controlar periféricos desde un celular que posea transmisión de datos MIDI sobre bluethoot.

Automatizar procesos en el estudio o en el vivo, tales como tener un control remoto via MIDI que nos permita manejar el programa de grabación de audio digital y hasta la automatización de la consola de sonido, y los sistemas de luces. y hasta controlar periféricos desde un celular que posea transmisión de datos MIDI sobre bluethoot.

¿Cómo el MIDI? ¿Como funciona?

Pensemos un momento, no bastó que los fabricantes se pusieran de acuerdo en crear de la noche a la mañana un estándar de comunicación. Había que inventar todos los elementos que intervienen en un proceso de transmisión de información: ¿Quién iba a hablar? (Emisor), ¿Quién iba a oír? (Receptor), ¿Cómo iba a hablar? (Por la boca MIDI OUT), ¿Cómo iba a oír? (Por la oreja MIDI IN), ¿Qué iba a decir? (Mensajes MIDI), ¿Cómo lo iba a decir? (Sintaxis y gramática del nuevo código de comunicación), y por donde iba a viajar esa comunicación (por el cable MIDI, y como información digital).

Se optó por aprovechar la nueva tecnología digital y sobre la base de ella se elaboró el sistema de comunicación, que se basó en una transmisión serial asincrónica. Es decir no es posible predecir cuando un paquete de datos va a viajar por el cable, ya que los datos dependen del intérprete y usualmente no tocan todas las notas ni mensajes al mismo tiempo, por eso no podía ser sincrónizada.

Pensemos en un telégrafo y en el código morse:

Los únicos dos elementos que poseemos para producir mensajes lógicos son el (.) y la (-). Las distintas combinaciones de puntos y rayas (la secuencia puede ser muy larga), y la convención de asignarles un significado especial en el cual todos los que adoptan el código están de acuerdo, es más o menos la elaboración de un sistema de comunicación binario.

Si un navegante tipea en su telégrafo la señal S.O.S. (traducida en puntos y rayas claro está), esa señal viajará por el aire (traducida en radio frecuencia) hasta llegar por ejemplo a la base de prefectura en tierra. La señal será decodificada por el otro operador de telégrafo, quién reaccionará por ejemplo mandando un barco hasta el lugar o enviando un helicóptero. El mensaje fue entendido como un pedido de auxilio, pero como ves la reacción del receptor puede ser diferente y depende de él mismo.

De manera similar por el cable MIDI viajan órdenes, dichas órdenes generan en los receptores una respuesta que puede ser la emisión de un sonido, pero la calidad, el timbre del sonido, etc., es siempre responsabilidad del receptor del mensaje. (o de su fabricante, mejor dicho).

Como funciona en una conexión simple el MIDI:

Insistimos: En ningún caso lo que viaja por el cable es sonido, sino órdenes que hacen que el receptor emita sonidos. La comunicación está dada en dirección desde el emisor hacia el receptor. La salida de mensajes se efectúa por el puerto “OUT”, es como una boca que emite ideas propias. La entrada de mensajes se realiza por el puerto “IN”, y es como una oreja que todo lo escucha.

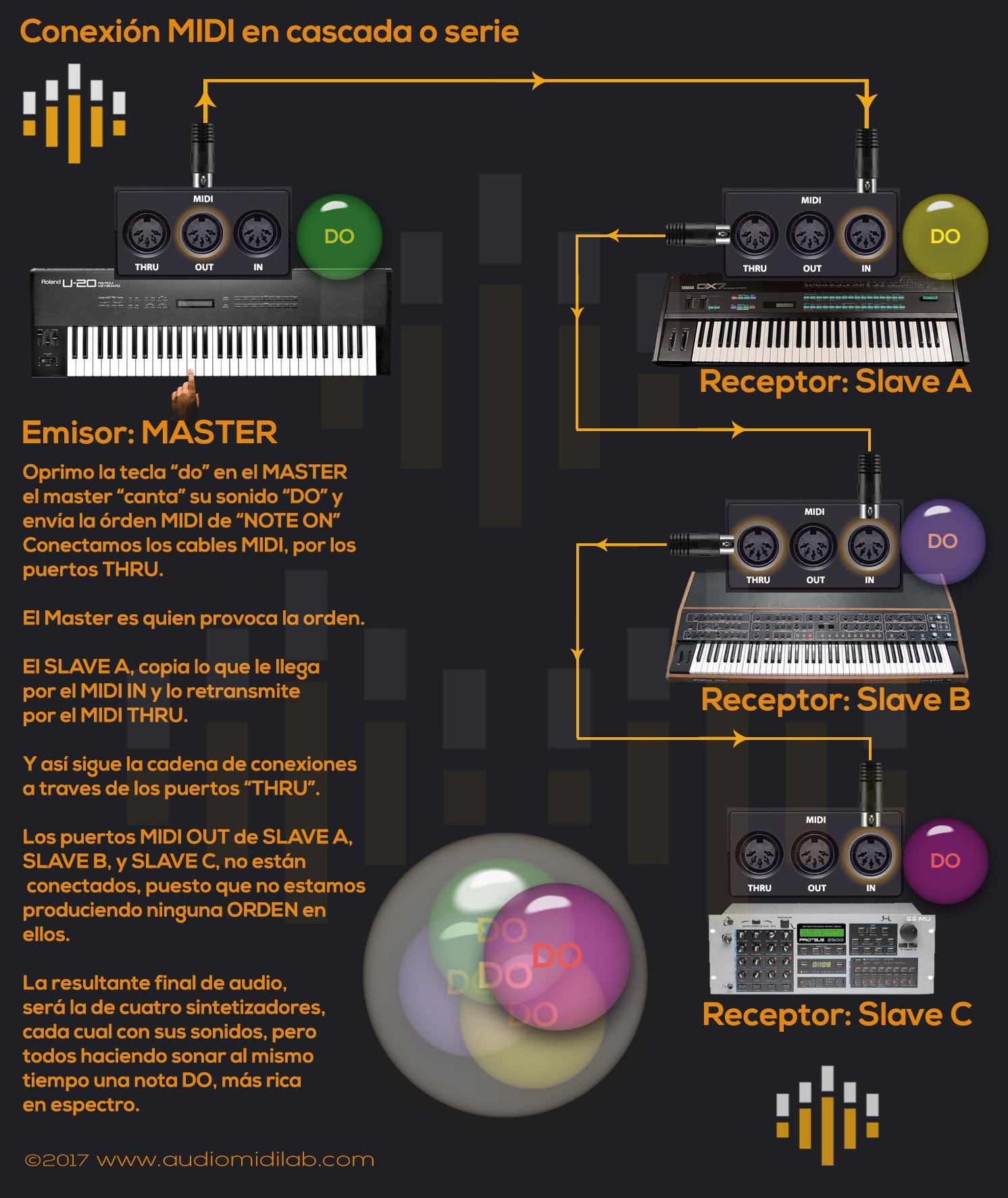

El puerto “THRU”, es también un puerto de salida de datos pero no emite ninguna idea original, es decir es como una boca de loro, solo repite lo que le llega por el “IN“ (oreja). En realidad el puerto THRU se utiliza para poder armar cadenas de conversación entre más de dos teclados. Como regla general siempre conectaremos un «OUT» a un «IN», ó un «THRU» a un «IN», ninguna otra conexión funciona. En terminología MIDI al emisor del mensaje se lo llama: Controlador y al Receptor: Esclavo.

Cuando intervienen varios sintetizadores en una conversación MIDI:

Cuando intervienen varios sintetizadores, es cuando empieza a tener sentido el uso del puerto MIDI THRU. El puerto THRU es un puerto de salida de datos. Pero a no confindirse. Son datos re transmitidos de lo que llega por el MIDI IN. En tanto que el puerto MIDI OUT se encarga de sacar datos originados dentro del propio teclado, el puerto THRU, hace una copia de lo que llega por el IN. Y se utiliza justamente en conexiones donde intervienen más de dos periféricos MIDI.

Se resuelve de esta forma una de las necesidades originales de la tecnología musical: ¡Obtener un espectro más rico! Establecida de ese modo la red MIDI podemos obtener timbres mucho más ricos y poderosos a partir de un único controlador que envía sus órdenes a más de un periférico.

¿Conclusiones?

Muchos se estarán preguntando o planteando diversas situaciones, a saber: ¿Que ocurre si quiero tocar con una mano en cada teclado? ¿Puedo tener mas de un master? ¿Como hago para que no suenen todos al mismo tiempo? ¿Puedo tocar un bajo con la mano izquierda y un piano con la derecha en el mismo master?

Y la respuesta que da el MIDI es siempre: ¡SI!.

Es muy importante que comprendamos que sin MIDI no hay producción musical, asi nunca uses un sintetizador. Todos los mensajes de automatización de mezcla en tu DAW, utilizan el protocolo MIDI para registrarse. Si necesitas sincronizar una producción de audio digital con la imagen, probablemente uses MIDI TIME CODE. Es decir, el MIDI es innegable. Tarde o temprano lo vas a necesitar. Cuanto antes lo comprendas, mejor preparado estarás.

Esta cadena de datos no termina simplemente aquí, a lo largo de los siguientes episodios iremos profundizando en el protocolo de comunicación en sí mismo. Espero que haya sido de su interés lo que planteo en este episodio y los invito a seguir investigando.

Angel Diego Merlo.

El presente artículo ha pasado las verificaciones del Consejo Académico de Audiomidilab, y por lo tanto se encuentra certificado por los especialistas del área. Eso quiere decir que es formalmente correcto y resulta ser una fuente de información confiable. Todo artículo que escribe un autor o submite un corresponsal o colaborador, es pasado por este riguroso sistema de certificación.

El presente artículo ha pasado las verificaciones del Consejo Académico de Audiomidilab, y por lo tanto se encuentra certificado por los especialistas del área. Eso quiere decir que es formalmente correcto y resulta ser una fuente de información confiable. Todo artículo que escribe un autor o submite un corresponsal o colaborador, es pasado por este riguroso sistema de certificación.

©2004 – 2023 Audiomidilab.com. Fuente: Libro «Música con computadoras» Diego Merlo – ISBN 987-9131-31-2. Usado con autorización expresa del autor. Todos los derechos reservados. El editor puede haber incluido contenidos audiovisuales en enlaces externos que corresponden a terceros. Invocando el derecho a cita con fines educativos.